जब एआई मॉडल लिंग असमानताओं को बढ़ावा देते हैं, महिलाएँ उस एल्गोरिद्म को फिर से लिख देती हैं।

कृत्रिम बुद्धिमत्ता (एआई) आधारित भर्ती उपकरणों में पुरुषों को असामान्य रूप से प्राथमिकता देने का रुझान पाया गया है, जबकि बड़े भाषा मॉडल लिंग आधारित पूर्वाग्रहों को बढ़ावा देने की प्रवृत्ति दिखाते हैं, जिसमें महिलाओं को देखभाल भूमिकाओं से और पुरुषों को पेशेवर सफलता से जोड़कर देखा जाता है।

सैश्या दुग्गल द्वारा

| प्रकाशित: 6 मार्च, 2025

कल्पना कीजिए कि आप एक महिला* के रूप में एआई-संचालित होम लोन प्रणाली के माध्यम से लोन के लिए आवेदन कर रही हैं। आपकी स्थिर आय और मजबूत क्रेडिट इतिहास भी आपको ‘उच्च जोखिम’ के रूप में चिन्हित होने से नहीं बचा पाएगी, जबकि उसी वित्तीय प्रोफ़ाइल वाले एक पुरुष आवेदक को मंजूरी मिल जाएगी। क्यों? एल्गोरिद्म उन प्रणालीगत असमानताओं को ध्यान में नहीं रखता जो महिलाओं को प्रभावित करती हैं, और अनजाने में उस विषयकता को बढ़ावा देता है जिसे इसे समाप्त करने के लिए बनाया गया था।

यह व्यापक स्तर पर होने वाला रूढ़िवाद सिर्फ एक बार की घटना नहीं है। यह पाया गया है कि कृत्रिम बुद्धिमत्ता (एआई) आधारित भर्ती उपकरणों में पुरुषों को असामान्य रूप से प्राथमिकता दी जाती है, जबकि बड़े भाषा मॉडल (एलएलएम) लिंग पूर्वाग्रहों को बढ़ावा देने की प्रवृत्ति दिखाते हैं, महिलाओं को देखभाल भूमिकाओं और पुरुषों को पेशेवर सफलता से जोड़ते हैं। इसी तरह, घर आधारित वर्चुअल असिस्टेंट जिन्हें उपयोगकर्ताओं की सेवा के लिए सहज बनाया गया था, उन्हें प्रारंभ में डिफ़ॉल्ट रूप से स्त्रीलिंग आवाज दी गई थी, जबकि कैंसर उपचार में निर्देश देने और डॉक्टरों के साथ काम करने वाले असिस्टेंट को पुंलिंग आवाज दी गई थी। एआई के खतरे और वादे केवल एक प्रॉम्प्ट से अलग होते हैं, लेकिन यह प्रॉम्प्ट उस पितृसत्तात्मक मानसिकता द्वारा पहले ही दर्ज किया गया था, जब यह तकनीक व्यापक रूप से प्रचलित भी नहीं हुई थी।

हालाँकि उन्होंने भौतिकी में शिक्षा ग्रहण की, आचार्य जीनोमिक्स उद्योग की एक प्रतिष्ठित हस्ती बन गई हैं।

क्या: हेल्थ टेक का एक (उपयोग) मामला

अनु आचार्य, मैपमायजीनोम की सीईओ हैं, जो एक जीनोमिक्स कंपनी है और ग्राहकों के स्वास्थ्य और तंदुरुस्ती को बेहतर बनाने के लिए डीएनए-आधारित परीक्षण प्रदान करती है। उनके लिए मशीन लर्निंग एक ऐसा उपकरण है जो जीनोमिक और रक्त डेटा को एकीकृत कर व्यापक स्कोर विकसित करने और भविष्यवाणी संबंधी अंतर्दृष्टि देने में मदद करता है, जैसे व्यक्तियों की जैविक उम्र का अनुमान लगाना।

जब उनसे स्वास्थ्य देखभाल में एआई के उपयोग मामलों के बारे में पूछा गया, तो आचार्य आशावादी नजर आती हैं, हालांकि यह स्वीकार करते हुए कि स्वास्थ्य देखभाल के अधिकांश डेटासेट “पुरुष, सफेद और कोकेशियाई” हैं। उनका आशावाद सतर्क है, जो एआई चिकित्सा में हुई प्रगति जैसे सटीक निदान, गैर-आक्रामक प्रारंभिक पहचान विधियाँ और उच्च जोखिम वाले क्षेत्रों और आबादी की पहचान में स्वास्थ्य देखभाल की पहुंच बढ़ाने जैसी सफलताओं से उत्पन्न हुआ है। फिर भी, यह वास्तविकता की कसौटी पर संतुलित रहता है। एआई की रूपांतरणकारी क्षमता इस बात पर निर्भर करती है कि आधारभूत मॉडलों में मौजूद प्रणालीगत पूर्वाग्रहों को दूर किया जाए। चाहे मॉडल कितना भी उन्नत क्यों न हो, यदि इसका निर्माण समानतापूर्ण नहीं है, तो यह देखभाल में मौजूदा असमानताओं को बढ़ावा देने का जोखिम रखता है।

हृदय रोग निदान में एआई के उपयोग का उदाहरण लें। एक पिछली अध्ययन में पाया गया कि हृदय संबंधी रोग और हृदय असफलता का पता लगाने की सटीकता महिलाओं के लिए पुरुषों की तुलना में कम थी। यह पूर्वाग्रह आधारहीन नहीं है, बल्कि वास्तविक दुनिया में देखभाल की असमानताओं को दर्शाता है, जिसने लंबे समय से महिलाओं को नुकसान पहुंचाया है। विशेष रूप से, डॉक्टर हृदयाघात के बाद या आपातकालीन विभाग में स्ट्रोक के लक्षणों के लिए महिलाओं को गलत निदान देने की अधिक संभावना रखते हैं।

आचार्य बताती हैं कि ये समस्याएँ क्लिनिकल ट्रायल में महिलाओं के व्यवस्थित हाशिए पर रखे जाने से और बढ़ जाती हैं — जो शुरू में इस अब खारिज हो चुकी धारणा के कारण था कि हार्मोनल उतार-चढ़ाव और लिंग-विशिष्ट पैरामीटर महिलाओं के डेटा को कम विश्वसनीय बनाते हैं। इसके अतिरिक्त, गर्भवती महिलाओं को संभावित जोखिम के कारण ट्रायल में भागीदारी से बाहर रखा जाना और महिलाओं की भागीदारी से जुड़े वित्तीय और कानूनी खर्च भी पर्याप्त महिला प्रतिनिधित्व न होने का कारण बनते हैं।

आचार्य बताती हैं कि इस कम प्रतिनिधित्व के कारण महिलाओं के स्वास्थ्य संबंधी मुद्दों जैसे पीसीओएस, रजोनिवृत्ति और एंडोमेट्रियोसिस पर पर्याप्त डेटा की कमी रहती है। वह “शिकायत करती महिलाएँ” नामक घटना का हवाला देती हैं, जहां महिलाओं की दर्द संबंधी शिकायतों को स्वास्थ्य अधिकारियों द्वारा दस्तावेजीकरण की कमी के कारण बिना मदद के खारिज कर दिया जाता था। ये सभी पूर्वाग्रह वर्तमान में जिन चिकित्सा डेटा पर एआई मॉडल प्रशिक्षित किए जा रहे हैं, उनमें परिलक्षित होते हैं। इसका परिणाम असमान उपचार सिफारिशों, पुरुषों के शरीर के अनुसार दवाओं की खुराक जैसी समस्याओं के रूप में सामने आता है।

क्यों: एआई पूर्वाग्रह के तकनीकी पहलू

आचार्य का तर्क स्वास्थ्य देखभाल में एआई में मौजूद पूर्वाग्रहों से आगे जाता है। उनका मानना है कि यदि महिलाओं की समस्याओं को शुरू से ही दस्तावेज़ित नहीं किया गया, तो उन्हें एआई सिस्टम द्वारा निर्णायक रूप से हल नहीं किया जा सकेगा। इसका अर्थ यह है कि पूर्वाग्रह केवल उस डेटा से उत्पन्न नहीं होता जिस पर एआई मॉडल प्रशिक्षित होता है, बल्कि यह सिस्टम के डिज़ाइन की बुनियाद में ही समाहित हो सकता है, जो अक्सर यह निहित स्टीरियोटाइप दर्शाता है कि पुरुषों की ज़रूरतें डिफ़ॉल्ट हैं। इस प्रकार, जब एआई को किसी विशेष जनसांख्यिकीय समूह की सेवा के लिए बनाया जाता है, तो अन्य समूह अनजाने में उपेक्षित, सक्रिय रूप से हाशिए पर डाल दिए जाते हैं, या यहां तक कि नुकसान भी पहुंचा सकते हैं।

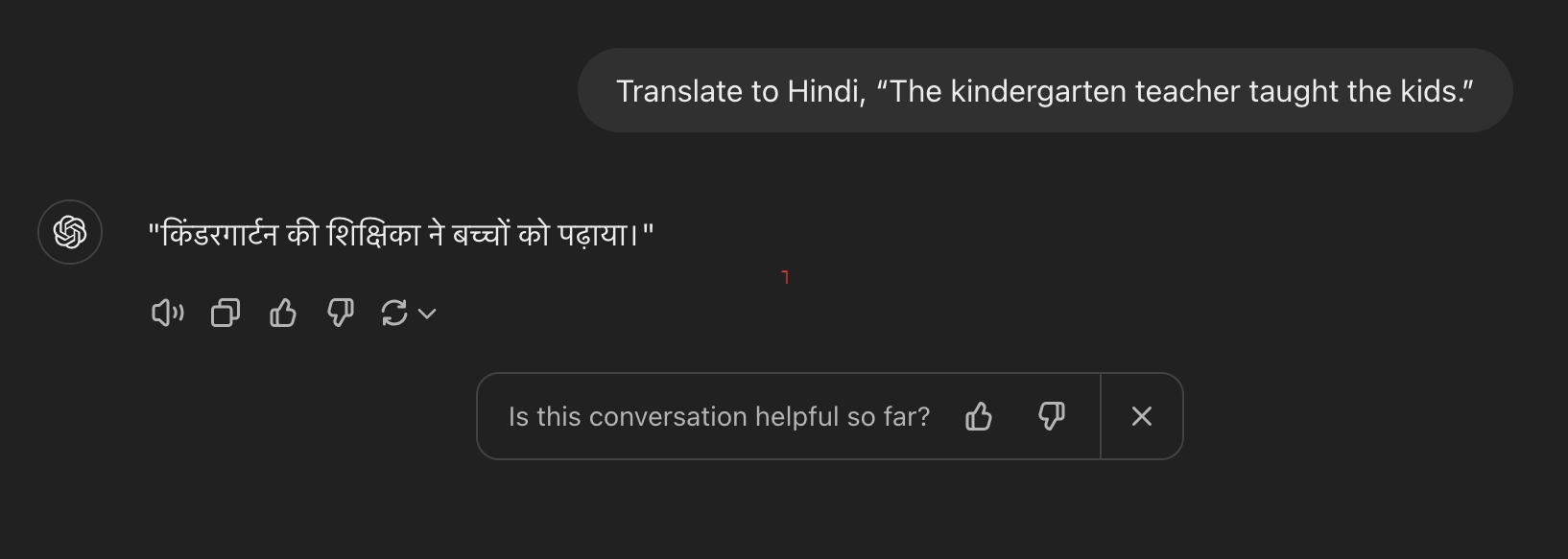

कुछ मूल्यांकनकर्ता इसे पक्षपाती अनुवाद मान सकते हैं, जबकि अन्य इसे हमारे समय की व्यावहारिक वास्तविकता को दर्शाने वाला मानते हैं, जहां अधिकांश प्राथमिक शिक्षक महिलाएँ हैं।

गुप्ता ने एलएलएम इकोसिस्टम में लिंग की स्थिति पर एक रिपॉज़िटरी सह-लेखित

की है; यह DFL के नोटियन साइट पर उपलब्ध है।

कुछ उदाहरणों में सबसे स्पष्ट उदाहरण महिलाओं के खिलाफ डीपफेक तकनीक का हथियार बनाना है — डीपफेक ऐसे एआई-जनित और बदले गए मीडिया हैं, जो अत्यधिक यथार्थवादी लेकिन पूरी तरह से कृत्रिम छवियाँ या वीडियो बनाते हैं। शोध के अनुसार, पुरुष किसी भी महिला की छवि आधारित या कृत्रिम मीडिया दुर्व्यवहार करने की अधिक संभावना रखते हैं, अक्सर डीपफेक का उपयोग गैर-सहमति यौन सामग्री बनाने के लिए करते हैं। यह पारंपरिक मीडिया में स्थापित पैटर्न के अनुरूप है, जहां यौन सामग्री पुरुषों की कल्पनाओं को ध्यान में रखकर बनाई जाती थी; डीपफेक उद्योग, जिसमें नैतिक सुरक्षा उपायों की कमी है और जो पुरुष उपभोक्ताओं द्वारा संचालित होता है जो स्पष्ट सामग्री की मांग करते हैं, अक्सर इन लिंग-आधारित पूर्वाग्रहों को दोहराता है। उदाहरण के लिए, अब बंद हो चुकी ऐप, डीपन्यूड, ने किसी भी महिला की फोटो को “नग्न” बनाने के लिए एआई का उपयोग किया, लेकिन पुरुष की फोटो के लिए यह प्रभावी रूप से काम नहीं कर पाया।

तकनीकी दृष्टि से, एआई विकास का जीवनचक्र ऐसे तत्वों से भरा होता है जो पूर्वाग्रह को बढ़ावा देते हैं, कहती हैं आरोशी गुप्ता, रिसर्च मैनेजर, डिजिटल फ्यूचर्स लैब, जो प्रौद्योगिकी और समाज के बीच बातचीत पर केंद्रित एक शोध नेटवर्क है। उनका विश्लेषण बड़े भाषा मॉडल (एलएलएम) के उपयोग का ऐसे महत्वपूर्ण सामाजिक क्षेत्रों में, जैसे यौन और प्रजनन स्वास्थ्य (SRH) और लिंग-आधारित हिंसा (GBV), में यह दर्शाता है कि प्रक्रिया के विभिन्न चरणों में प्रणालीगत कमियाँ उभरती हैं।

एक प्रमुख समस्या पूर्व-प्रशिक्षित बेस मॉडल जैसे GPT, Llama, या Claude के चयन में निहित है; सामान्यतः इन्हें उनकी सटीकता और लागत-कुशलता के आधार पर चुना जाता है, जबकि इनके अंतर्निहित पूर्वाग्रहों पर सीमित विचार किया जाता है। कस्टमाइज़ेशन के दौरान पूर्वाग्रह और अधिक स्पष्ट हो जाता है — उदाहरण के लिए, जब एक SRH चैटबॉट मॉडल को मेडिकल जर्नल या सरकारी दिशानिर्देशों के डेटा से बढ़ाया जाता है (रिट्रीवल-ऑगमेंटेड जेनरेशन के माध्यम से), तो यह अनजाने में:

महिलाओं का कम प्रतिनिधित्व कर सकता है, यदि प्रशिक्षण डेटा में पूर्वाग्रह मौजूद हैं;

सैम्पलिंग पूर्वाग्रह को बढ़ा सकता है, जैसे कि गरीब या ग्रामीण पृष्ठभूमि वाली महिलाओं को शामिल न करना;

अनुवाद में पूर्वाग्रह को बढ़ा सकता है, क्योंकि सांस्कृतिक या भाषाई मान्यताओं के कारण वर्ड एम्बेडिंग मॉडल लिंग-तटस्थ भाषाओं (जैसे अंग्रेज़ी) से व्याकरणिक रूप से लिंगित भाषाओं (जैसे हिंदी) में अनुवाद करते समय लिंग को गलत तरीके से असाइन कर सकता है; और

एनोटेशन पूर्वाग्रह उत्पन्न कर सकता है, क्योंकि डेटा को वर्गीकृत करते समय एनोटेटर्स के मान्यताओं को प्रतिबिंबित किया जाता है। उदाहरण के लिए, GBV जैसे संदर्भों में, हानिकारक या अपमानजनक सामग्री क्या है, इसे व्यक्तिपरक रूप से व्याख्यायित किया जाता है, जिससे एनोटेटर्स के बीच सहमति की कमी रहती है और एआई मॉडल हानिकारक लिंग-आधारित सामग्री को सही ढंग से संबोधित करने में विफल रहता है।

पूर्वाग्रह एआई मॉडल के मूल्यांकन चरण में भी व्याप्त होता है — लिंग आधारित मूल्यांकन दृष्टिकोण करना चुनौतीपूर्ण होता है क्योंकि लिंग पूर्वाग्रह अक्सर सूक्ष्म और संदर्भ-निर्भर रूप में प्रकट होते हैं और सार्वभौमिक रूप से पहचाने नहीं जा सकते। गुप्ता यह भी रेखांकित करती हैं कि भारतीय आबादी के लिए विशेष रूप से बेंचमार्किंग डेटासेट की कमी है, जो एआई मॉडल की सटीकता, निष्पक्षता और पूर्वाग्रह का आकलन करने में महत्वपूर्ण हैं और लिंग पूर्वाग्रह मूल्यांकन को बेहतर तरीके से लागू करने में मदद करती हैं।

करने के लिए: महिलाओं के नेतृत्व वाले एआई लैब कैसे मदद कर सकते हैं

क्या आप एआई में निहित प्रणालीगत पूर्वाग्रहों से निपटने के समाधान खोज रहे हैं? सिर्फ समस्या को देखना पर्याप्त नहीं है, यह यह समझने के बारे में भी है कि इसे कैसे हल किया जाए। प्रोफेसर पायल अरोड़ा, इंक्लूसिव एआई में अग्रणी और इंक्लूसिव एआई लैब व FemLab.Co की सह-संस्थापक, पारंपरिक समाधानों जैसे नीति से आगे देखने की आवश्यकता पर जोर देती हैं।

“नियमन पर्याप्त नहीं होगा,” वह बताती हैं, यह उजागर करते हुए कि टेक्नोलॉजी दिग्गजों के विशाल वित्तीय संसाधन उन्हें एआई के विकास और कार्यान्वयन पर असमान शक्ति प्रदान करते हैं, जिससे ग्लोबल साउथ के देशों की सीमित क्षमता रहती है कि वे इसकी दिशा को अधिक न्यायसंगत परिणामों की ओर चुनौती दें या पुनर्निर्देशित करें।

अरोड़ा की इंक्लूसिव एआई लैब यहीं पर भूमिका निभाती है, जो एडोब और गूगल जैसे दिग्गजों के प्रमुख एआई, UI और UX उद्योग नेताओं के साथ सहयोग करती है, ताकि एआई विकास प्रक्रिया से नियमित रूप से बाहर रह जाने वाली विविध आवाज़ों और कारणों को बढ़ाया जा सके। अरोड़ा के अनुसार, यह लैब जानबूझकर क्रॉस-सेक्टोरल है, लेकिन अनजाने में — और सौभाग्य से — महिलाओं के नेतृत्व वाली है।

अरोड़ा की पुस्तक, जिसका शीर्षक ‘From Pessimism to Promise’ है, ग्लोबल साउथ में एआई की स्थिति पर उनके शोध को उजागर करती है।

लैब का तकनीकी कार्य दो तरह का है: सबसे पहले, वे सिंथेटिक, पूर्वाग्रह-मुक्त (de-biased) डेटासेट तैयार करते हैं, जो मौजूदा डेटा में मौजूद खामियों को पूरा करने के लिए डिज़ाइन किए जाते हैं। ये डेटासेट समानतापूर्ण डेटा को दोहराते हैं या यह दर्शाते हैं कि ऐसा डेटा कैसा दिख सकता है, जिससे एआई मॉडल अधिक प्रतिनिधि उदाहरणों से सीख सकें। अरोड़ा बताती हैं कि यह प्रक्रिया अधिक स्केलेबल और स्थानीयकृत डेटा समाधान सक्षम करती है, उन कंपनियों की जरूरतों को पूरा करती है जो अपने डेटा में समानता चाहती हैं लेकिन उनके पास संसाधन, विशेषज्ञता, आधारभूत ढांचा और/या सूक्ष्मता की कमी होती है। दूसरी बात, वे पूरी तरह नए, प्रतिनिधि डेटासेट विकसित करते हैं।

“यह केवल मौजूदा डेटासेट को दोहराने के बारे में नहीं है, बल्कि नए, समानतापूर्ण डेटासेट बनाने के बारे में है,” अरोड़ा कहती हैं। वह और उनकी टीम अपने ताज़ा विकसित किए गए डेटासेट को क्रिएटिव कॉमन्स पर प्रकाशित करती हैं, एक ऐसा प्लेटफ़ॉर्म जो इन्हें व्यापक दर्शकों द्वारा सहयोग और सामूहिक समस्या समाधान के लिए इस्तेमाल करने योग्य बनाता है।

लैब उन क्षेत्रों में भी योगदान देती है जहाँ एआई मॉडल काफी पीछे हैं। भर्ती एल्गोरिदम में पूर्वाग्रह समाप्त करने के लिए, लैब नई तरह की बायोडाटा (curricula vitae) विकसित कर रही है, जो विशेष रूप से अधिक महिलाओं — खासकर रंगीन महिलाओं — को शामिल करने के लिए सोच-समझकर डिज़ाइन की गई हैं। इसी तरह, जेनेरेटिव एआई (GenAI) के संदर्भ में सुरक्षा और जवाबदेही की कमी से निपटने के लिए, लैब जल्द ही गूगल के साथ सहयोग करेगी ताकि ग्लोबल साउथ की महिलाओं को गैर-सहमति एआई-जनित मीडिया के खिलाफ निवारण तंत्र उपलब्ध हो सके।

अजीब लेकिन दिलासा देने वाली बात यह है कि एआई में लिंग पूर्वाग्रह की व्यापक उपस्थिति के बावजूद, इन तीनों महिलाओं का भविष्य के प्रति आशावाद अप्रत्याशित रूप से मजबूत है। गुप्ता “पूरा उद्योग दोषी नहीं ठहरातीं”, क्योंकि उन्होंने ऐसे डेवलपर्स के साथ काम किया है जो अपने उत्पाद को लिंग प्रतिनिधि बनाने के लिए प्रतिबद्ध हैं। अरोड़ा ऐसे उदाहरण देती हैं कि कैसे उत्पीड़क शासन में, विशेष रूप से महिलाओं द्वारा नेतृत्व वाली विरोध संस्कृतियों ने एआई का उपयोग अपनी लड़ाई की छवियाँ उत्पन्न करने के लिए किया, बिना “वास्तविक” लोगों को शामिल किए।

जब अरोड़ा कहती हैं कि ग्लोबल साउथ के लोगों को उनके जन्म के संदर्भ में सीमित नहीं किया जाना चाहिए, तो वह एआई पर भी एक महत्वपूर्ण चिंतन कर रही हैं। जो वर्तमान में इसकी उत्पत्ति की सीमित धारणाओं को प्रतिबिंबित कर रहा है, उसे इसके बजाय सीमाओं को पार करने और सभी को सशक्त बनाने के लिए डिज़ाइन किया जाना चाहिए, चाहे उनकी शुरुआत कहीं से भी हुई हो।

*यह लेख एआई सिस्टम में लिंग असमानताओं पर केंद्रित है, विशेष रूप से सिस-हेटरो महिलाओं के अनुभवों को संबोधित करता है।

ज़रूरी सूचना: यह लेख एआई की सहायता से हिंदी में अनुवादित किया गया है। इसमें कुछ अशुद्धियाँ या असंगतियाँ संभव हैं।

लेखक के बारे में

सैश्या दुग्गल एक सार्वजनिक नीति और प्रभाव परामर्श (public policy and impact consulting) पेशेवर हैं, जो प्रौद्योगिकी, वित्त और जलवायु नीति के संगम पर काम करती हैं। उन्होंने यूपी सरकार, वर्ल्ड बैंक समूह और भारतीय एनबीएफसी के साथ परियोजनाएँ संचालित की हैं। दिल्ली विश्वविद्यालय की स्नातक, उनका कार्य नीति में STEM (विज्ञान, प्रौद्योगिकी, इंजीनियरिंग और गणित) के मूल्य और उसके कार्यान्वयन पर जोर देता है। उनके पिछले पेशेवर अनुभवों में Invest India और Ericsson में कार्य शामिल हैं।

Add a Comment